Die Automatisierung der Kommunikation

Wenn Maschinen wie Menschen klingen

Die Zeiten, in denen man von einem Anbieter für ein Verkaufs- oder ein Beratungsgespräch im Telefonbuch eine Nummer heraussuchte, dort anrief und von einer mehr oder weniger kompetenten Person mit dem passenden Mitarbeiter verbunden wurde, sind vorbei. Wer beispielsweise einen Flug oder einen Mietwagen buchen möchte, wer Strom, Gas, Telefon oder einen neuen Internetanschluss anmelden muss, bekommt es oft mit einem nicht immer logisch aufgebauten und sprachlich missverständlichen Chatbot zu tun: „Haben Sie Fragen zur Rechnung, antworten sie mit ja.“ Dann folgen weitere Optionen, aber nicht immer ist das eigene Anliegen dabei, oder es ist nicht ganz klar, ob es sich eher der Rubrik „Technik“, „Vertrag“ oder „Störung“ zuordnen lässt. Die Möglichkeit, mit einem Menschen zu sprechen, wird nur selten angeboten: Manchmal stellt ein der menschlichen Stimme nachempfundener Bot die Frage: „Wie kann ich Ihnen sonst weiterhelfen?“. Allerdings versteht er das Anliegen nur selten. Sollte ein Mitarbeitergespräch angeboten werden, landet man in einer meist unendlich langen Warteschleife.

Chatbots als preiswerte Mitarbeiter

Hinter vielen automatisierten Callcentern stehen Chatbots. Serviceleistungen von menschlichen Mitarbeitern sind teuer, die Maschine dagegen kennt keine Freizeit, sie wird nicht krank und braucht keine Pausen. Die Mitarbeiter können sich auf die Abwicklung der Geschäfte konzentrieren, die man (noch) nicht der Künstlichen Intelligenz (KI) überlassen kann.

Chatbots sind aber weit davon entfernt, einen Mitarbeiter zu ersetzen: Wer nicht gemäß programmierter Standards antwortet oder undeutlich spricht, wird oft falsch oder gar nicht verstanden. In einer Studie des Kundendienst-Software-Anbieters Freshworks aus dem Jahr 2019 gaben 56 % der Befragten an, nach einer unbefriedigenden Erfahrung mit einem Chatbot das Interesse an dem Produkt verloren zu haben. 92 % haben den Bot übel beschimpft, weil er nicht weitergeholfen hat (vgl. E-Commerce Magazin 2020).1 Jens Leucke, Country Manager für die DACH-Region bei Freshworks, sieht in KI-basierten Chatbots dennoch großes Potenzial: „KI kann dabei helfen, die Kundenkommunikation stärker zu personalisieren und die Interaktion mit Bots zu verbessern. Zusätzlich können Unternehmen durch künstliche Intelligenz und die automatische Analyse der bereits gegebenen Antworten Einsicht in das Verhalten oder die Vorlieben ihrer Kunden erlangen und so auch auf Vorlieben von Kunden besser eingehen. Im Ergebnis können sich Kunden besser verstanden fühlen; dadurch wird Frustration auf Kundenseite vermieden – und somit sicher auch beleidigende Sprache reduziert” (ebd.). Chatbots haben aber auch Vorteile: „Wenn es um peinliche Fragen geht, sind digitale Gesprächspartner wiederum deutlich beliebter: 27 Prozent der befragten Menschen in Deutschland wenden sich mit Fragen an den Chatbot, bei denen es ihnen peinlich wäre, diese einem persönlichen Berater zu stellen“ (ebd.).

Die Kommunikation mit Chatbots funktioniert (noch) weitgehend über die Schriftsprache. Sie werden zur Kundenbindung, zu Fragen über Produkte und zu technischen Fragen eingesetzt, denn diese kommen in ähnlicher Weise immer wieder vor. Der Anbieter verfügt über ein reichliches Repertoire an Antworten, die er programmieren kann. Die richtige Schreibweise vorausgesetzt, ist zumindest sichergestellt, dass die Anfrage verstanden wird.

Wegen ihrer ständigen Verfügbarkeit werden die Bots immer beliebter. In einer Studie der Zürcher Hochschule für Angewandte Wissenschaften (ZHAW) gaben im Jahr 2021 63 % der Befragten an, dass sie schon einmal mit einem Chatbot kommuniziert hätten, „was eine Steigerung von 23 % im Vergleich zur 2018 realisierten Chatbot-Studie bedeutet“ (Swiss Moonshot AG 2021, S. 13). Circa 52 % nutzen sie üblicherweise am Abend oder am Wochenende (ebd., S. 19). Die Anwendungsbereiche sind: Termine vereinbaren, Informationen suchen, Lieferstatus abrufen – das sind relativ einfache Funktionen. Bei weiter gehenden Anwendungen wird es mit der schriftlichen Kommunikation schon schwieriger: 29,8 % der Befragten wünschen sich Hilfestellungen bei Problemen mit Produkten (ebd., S. 27), und dazu wären dialogfähige, stimmenbasierte Bots aufgrund der schnelleren Interaktion besser geeignet. Sie zu bauen ist allerdings sehr viel komplizierter, und die Entwicklung wird wohl noch eine Weile dauern.

Gesprochene Sprache ist komplex

Unser Ohr kann Umgebungsgeräusche unterdrücken und die Sprache herausfiltern. Stimmen können sehr verschieden klingen, und eine undeutliche Aussprache oder Dialekte erschweren das präzise Verstehen. Spracherkennungsprogramme zeigen, wie schwer es ist, gesprochene Sprache in Schriftsprache umzusetzen.

Davon ausgehend, dass Sprache vor allem syntaktischen Regeln folgt, versuchten Forscher der Computerlinguistik anfänglich das Problem der Verarbeitung natürlicher Sprache mithilfe von Computern durch das Formatieren der gängigen Wortarten und Satzstrukturen zu lösen. Dieser Ansatz führte jedoch nicht zu befriedigenden Ergebnissen, da er keinen Raum für Ausnahmen anbot: Es ist ein Grundverständnis von Zusammenhängen nötig, um die Bedeutung einer Phrase oder eines Wortes zu verstehen. Viele Wörter haben je nach Zusammenhang unterschiedliche Bedeutungen und Schreibweisen. Befehle und Satzzeichen müssen vom Text unterschieden werden, mit „Punkt“ kann ein Ort oder das Zeichen für das Satzende gemeint sein. Eine formale grammatikalische Analyse reicht somit nicht aus, um Sprache zu erfassen (vgl. Noetzel 2019).

Wachsende Speicher und Analysen von Wahrscheinlichkeiten

Das Problem war lange Zeit die geringe Speicherkapazität der Computer: Die Programme waren sehr langsam, die komplexen Daten sprengten ziemlich schnell das zur Verfügung stehende Speichervolumen. Eine wirkliche Hilfe beim Diktieren war die Spracherkennung lange nicht, der Trainingsaufwand war sehr groß. Abhilfe schafften das Machine Learning und wachsende Speicherkapazitäten. Inzwischen können Spracherkennungsprogramme durch die Extraktion von Mustern aus diversen Daten recht effektiv lernen (vgl. Kaplan 2017, S. 44).

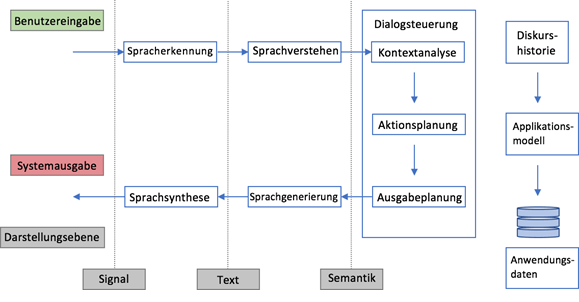

Heute ist die Spracherkennung viel genauer, die Programme müssen kaum noch trainiert werden und erkennen unterschiedliche Stimmen, allerdings sind sie immer noch weit davon entfernt, fehlerfrei zu arbeiten. Ähnlich klingende Wörter werden oft verwechselt, obwohl sie in dem jeweiligen Kontext keinen Sinn ergeben. Für ein Diktat sind Spracherkennungsprogramme einigermaßen hilfreich, für das Transkribieren von Interviews oder die Aufnahme von Diskussionen sind sie (noch) ziemlich unbrauchbar. Wer schon einmal versucht hat, sein Smartphone mit der Spracherkennung zu steuern, weiß, dass man oft falsch oder gar nicht verstanden wird. Wenn man allerdings bedenkt, wie komplex die menschliche Sprache gestaltet ist, sind die Fortschritte in der Spracherkennung doch äußert beachtlich. Für die Zukunft der Chatbots bedeutet das: Wird die Sprache erst korrekt verstanden, ist der Weg zu einem dialogfähigen Bot nicht mehr weit. Folgende Grafik zeigt die Funktionsweise moderner Chatbots:

Intelligenztests für KI

Die Idee, ein System zu bauen, mit dem man sich wie mit einem Menschen unterhalten kann, ist relativ alt. Bereits 1950 entwickelte der britische Informatiker Alan Turing den nach ihm benannten Turing-Test, der, wenn er erfolgreich durchlaufen wird, der Maschine attestiert, ebenso kommunikationsfähig zu sein wie ein Mensch: Wäre das der Fall, könnte man die Maschine als intelligent bezeichnen (vgl. Hoffmann 2018, S. 124).

An dem Test sind eine Maschine und zwei Menschen beteiligt, die sich gegenseitig nicht sehen können. Eine Person stellt schriftlich Fragen, die einmal von dem Menschen und einmal von der Maschine beantwortet werden. Anschließend muss der Fragestellende anhand der erhaltenen Antworten seinen Gesprächspartner als Mensch oder als Computer identifizieren. Wenn mehrere Menschen den Test durchlaufen haben und mindestens 30 % der Fragestellenden davon überzeugt sind, dass sie nicht mit einer Maschine kommuniziert haben, hat der Computer den Turing-Test bestanden (vgl. Goppy/Dowe 2003). Ob das allerdings wirklich ein Beweis für Intelligenz ist, kann bezweifelt werden. Denn es kann Zufall sein, dass bestimmte Fragen vom Computer erkannt werden und damit der Eindruck entsteht, es handele sich um einen Menschen, bei anderen Fragen hätte das vielleicht nicht geklappt. Mit Intelligenz hat ein bestandener Turing-Text wohl nichts zu tun, zumal der Computer den Inhalt der Fragen und Antworten nicht inhaltlich verstanden hat (vgl. Lotze 2016, S. 28).

Als einer der ersten Chatbots gilt ELIZA, ein 1966 von Joseph Weizenbaum entwickeltes Computerprogramm. ELIZA simuliert ein Gespräch mit einem Psychotherapeuten (vgl. Hoffmann 2018, S. 19). Seit ELIZA hielt man es für möglich, mit Computern zu kommunizieren (vgl. Huber et al. 2012, S. 12). Das Programm simulierte die Gespräche hauptsächlich durch das Umformulieren menschlicher Aussagen zu vorher programmierten Fragen. Diese Technik basiert auf dem Konzept des „aktiven Zuhörens“ nach dem US-amerikanischen Psychotherapeuten Carl Rogers. Aufgrund dieser Gesprächstechnik war es ELIZA möglich, ihr Gegenüber in lange Gespräche zu verwickeln und diese dabei von ihren psychotherapeutischen Fähigkeiten zu überzeugen. ELIZA war jedoch nicht in der Lage, sich an Gesprächsverläufe zu erinnern oder Rückschlüsse aus der Unterhaltung zu ziehen (vgl. Braun 2003, S. 27). Trotzdem löste ELIZA große Begeisterung aus, und es folgte eine Welle von Adaptionen und Weiterentwicklungen in diversen Programmiersprachen.

Chatbots werden immer besser

Für Unternehmen sind funktionierende Chatbots lukrativ. Und die Algorithmen werden ständig besser. Der Anbieter erfährt durch die Analyse der Kundenkommunikation, welche Probleme es gegeben hat, und erweitert die Algorithmen, um die Kundenbedürfnisse genauer zu erkennen und zu bedienen: Dabei bildet sich die künstliche Intelligenz allerdings (noch) nicht selbst weiter, sondern sie wird durch den Menschen entsprechend programmiert. Zwar macht das sogenannte Deep Learning oder Machine Learning beachtliche Fortschritte, aber die künstliche Intelligenz kann aus sich selbst heraus weder entscheiden noch bewerten oder selbst Lösungen entwickeln. Ihr scheinbares Verständnis von Inhalten beruht ausschließlich auf Algorithmen, die Daten auf der Grundlage von vorgegebener Wahrscheinlichkeit analysieren. KI bildet die Gedankengänge der Menschen ab, die sie entwickelt und dann entsprechend programmiert haben.

Anwendungsbereiche

Im Online-Servicebereich vieler Anbieter sind Chatbots, wie oben beschrieben, schon länger die Regel, obwohl hier ihre Schwächen besonders auffallen. Sehr praktisch sind sie im Bereich des Vorlesens von Texten, was nicht nur für Sehbehinderte eine große Hilfe darstellt. Für den Wissenschaftler, der lange Fachaufsätze lieber bei einem Spaziergang rezipieren will, bieten inzwischen einige Apps das Vorlesen von PDFs an. Die Qualität ist zwar immer noch weit von der professionellen Stimme eines geübten Sprechers entfernt, es klingt aber sehr viel besser als die früheren monotonen Computerstimmen, die man sofort als künstlich erkannt hat.

Vermutlich wird die Kundenkommunikation der oben beschriebenen bisherigen digitalen Systeme bald durch Chatbots in natürlich gesprochener Sprache ersetzt werden können, mit denen wir immer mehr so sprechen wie mit einem realen Mitarbeiter. In diesem Bereich wird sich die KI sowohl für Unternehmen als auch für Kunden erheblich verbessern.

Missbrauch

Schon in vergangenen Wahlkämpfen wurden Social Bots eingesetzt. Sie können, anders als Chatbots, keine Gespräche führen, sondern konzentrieren sich auf ideologische oder politische Propaganda und schaffen eine künstlich simulierte Reichweitenerhöhung bestimmter Meinungen in sozialen Netzwerken. Mithilfe von Social Bots lässt sich eine scheinbare gesellschaftliche Diskussion mit Tausenden Teilnehmern einfach programmieren, dabei wirkt es so, als seien dies reale Menschen. Die Bots reagieren in großer Masse auf bestimmte Hashtags und antworten mit vorgegebenen Phrasen. So erscheinen politische Richtungen auf sozialen Netzwerken als relevanter Trend, obwohl nicht Menschen, sondern Bots dahinterstecken (vgl. Hoffmann 2018, S. 13). Das kann von Politikern genutzt werden, aber auch Coronaleugner oder religiöse Extremisten können auf diese Weise den Anschein erwecken, sie seien viel mehr, als sie tatsächlich sind.

Synthetisch geklonte Stimmen

Dieses Problem wird sich in Zukunft noch verschärfen. Gegenwärtig wird daran gearbeitet, eine reale menschliche Stimme synthetisch so genau nachzubilden, dass man kaum noch zwischen dem realen Menschen und dem Bot unterscheiden kann.2 Der WDR Inovation Hub hat zusammen mit Microsoft einen Versuch gestartet, die Verkehrsnachrichten von Steffi Neu, einer im Sender sehr beliebten Stimme, vorlesen zu lassen – allerdings durch ihren synthetischen Klon. Das funktioniert gut und spart im Sender Arbeitsprozesse und Kosten (vgl. Roon 2021). Der Computer benötigt einige Sprechproben von vorgegebenen Sätzen – im Fall von Steffi Neu haben drei Stunden Sprachanalyse ausgereicht – und kann daraus einen stimmlichen Klon erstellen, der geschriebene Texte mit der Stimme der Sprechprobe vorliest.

Inzwischen können mit dem Programm TraficMeta Verkehrsmeldungen automatisch selektiert, individuell zugeschnitten und synthetisch mit der Stimme eines bekannten Sprechers an die Hörer verbreitet werden.3 Hat sich ein professioneller Sprecher bei der Aufnahme versprochen oder haben sich Fakten geändert, kann man das im Nachhinein mit dem synthetischen Klon problemlos korrigieren. Eine weitere Anwendungsmöglichkeit könnte im Synchronisieren von Spielfilmen liegen, vorstellbar beispielsweise wäre, dass die Originalstimme des Schauspielers geklont wird und dadurch die Synchronisation besonders authentisch wirkt.

Deep Fake

Bei seriösen Anbietern würde es wohl einen Hinweis auf diesen synthetischen „Fake“ geben. Wenn das Programm allerdings von Gruppen genutzt wird, die Falschmeldungen und extreme Meinungen verbreiten und dem Hörer beispielsweise vorgaukeln wollen, der bekannte Virologe Christian Drosten sei plötzlich zum Coronaleugner mutiert, könnte das fatale Folgen haben: Bestimmte Nachrichten würden eine viel größere Autorität und Glaubwürdigkeit erhalten, wenn sie durch die Stimme einer prominenten, kompetenten und allseits geschätzten Person vorgetragen würden. Während man bei Videos (noch) sehen kann, wer tatsächlich spricht, ist das bei einer Sprachübertragung nicht möglich und es kommt zu einem Deep Fake: Der Sender, wer auch immer das ist, kann mit der Stimme einer bekannten Persönlichkeit jeden Unsinn verbreiten. Die Fake News der Vergangenheit könnten also in Zukunft noch viel schwerer zu erkennen sein.

Auf der anderen Seite werden synthetische Stimmen in der Medizin hilfreich eingesetzt, um – wie dies im „Project Revoice“ der ALS Association versucht wird – eine aufgrund von Krankheit verloren gegangene Stimme nachzubilden.4

BWM isobar: ALS Association - Project Revoice, 15.03.2019

Reden mit Verstorbenen

Ebenso kann man seine eigene Stimme für die Nachwelt sichern, und der verstorbene Vater könnte, ganz ohne Mystik, weiterhin fast real mit seinen Nachfahren kommunizieren. Der digitale Friedhof wird hier noch um eine Variante ergänzt. Es hat sich bereits eine „Digital Afterlife Industry“ entwickelt (vgl. Simon 2018), wie Carl Öhmann und David Watsen das Phänomen in einer Studie der Universität Oxford nennen.5 In 50 Jahren, so die Studie, wird die Hälfte der Facebook-Profile Menschen gehören, die gar nicht mehr leben. Zu Lebzeiten kann man noch beeinflussen, ob und wie man seiner Nachwelt digital erhalten bleiben möchte, man muss allerdings die nötige Kenntnis sowie die Zeit dazu haben – und vor allem daran denken. Jedenfalls kann man davon ausgehen, dass der digitale Klon eines Verstorbenen hier in Zukunft auch einen Platz haben wird.

Die synthetische Wiederauferstehung Verstorbener könnte aber auch kommerziell sehr interessant sein. Man stelle sich vor, die Stimmen von Michael Jackson, John Lennon, George Harrison oder Amy Winehouse würden nachgebildet: Würden wir erkennen, ob es sich um das Original oder die synthetische Nachbildung handelt? Oder die Beatles könnten für Werbezwecke zum Beispiel singen: „All you need is Coke“ (Dworschak 2017).

Alexa, erzähle einen Witz!

Verbreitet sind, allen Bedenken der Datenschützer zum Trotz, sprachgesteuerte Chatboxen wie die von Amazon entwickelte Alexa. Sie bieten Zugang zu Streamingdiensten, Suchmaschinen und zu fast allen Radiosendern weltweit, sie können die neusten Nachrichten oder das Wetter irgendwo auf der Welt vorlesen. Woher diese Informationen allerdings stammen, erfährt der Nutzer nicht.

Eine Untersuchung des Instituts für Kommunikationswissenschaft der Universität Dresden hat die Seriosität der Nachrichten untersucht und festgestellt, dass diese zuweilen aus unsicheren, teils propagandistischen Quellen stammen. „Ein Grund für die teils irreführende Kategorisierung könne die Selbsteinordnung durch die Informationsanbieter sein […]. Denn weder Google noch Amazon würden den Informationsanbietern Richtlinien für die Einordnung vorgeben. ‚Inwiefern eine Prüfung der Einordnung stattfindet, ist zum aktuellen Zeitpunkt unklar.‘ Für die Studie untersuchte das Autorenteam von Februar bis Mai 2021 das Nachrichtenangebot der Sprachassistenten. Bei Amazon Alexa wie auch Google Assistant seien zudem nicht für alle Apps verlässliche Angaben zum Urheber vorhanden. Häufig seien die Entwickler der App als Urheber angegeben, aber nicht die Verantwortlichen für die Produktion der Inhalte. Ein Impressum mit klarer und transparenter Trennung von Verantwortlichen für die Inhalte und die technische Umsetzung sei nicht bei allen Apps vorhanden. In der Studie werden zudem die Auswahl-Kriterien der Medienangebote kritisiert. Vor allem über die Nutzung der Standard-Einstellungen der Sprachassistenten sei nur eine kleine Auswahl an Medienangeboten enthalten […]“ (epd 2021).6

Datenschutz

Die Sprachassistenten werden über Sprachbefehle gesteuert und reagieren auf Signale: „Hey Siri“ oder „Alexa“, und schon sind sie bereit für weitere Anweisungen. Die Programme schalten sich jedoch auch auf ähnlich klingende Wörter ein und „hören“ dann eine Weile mit, ohne dass der Nutzer dies ahnt. Die Befehle und die gelungene oder missglückte Interaktion mit der Box werden vom Anbieter vermutlich dokumentiert und ausgewertet, und so können die Algorithmen ständig überarbeitet und optimiert werden – ob sich das mit dem Datenschutz verträgt, ist dabei eine andere Frage (vgl. Zinner 2020).

Dass auch die persönlichen Gespräche im Raum mitgehört und gespeichert werden, selbst wenn die Box gar nicht aktiviert ist, wird von vielen vermutet. Mit entsprechender KI könnte man immer genauere Persönlichkeitsprofile aus den Daten entwickeln, diese vermarkten und beispielsweise Kaufverhalten oder Wahlpräferenzen prognostizieren. 2019 konnte das US-amerikanische Medienunternehmen Bloomberg nachweisen, dass private Gespräche durch Alexa übertragen wurden. Amazon hat darauf reagiert und bietet den Kunden nun die Möglichkeit an, dieses Mithören abzustellen (vgl. Martin 2019). Aber wer kann schon kontrollieren, ob die Abschaltfunktion tatsächlich funktioniert? Unsere Befehle und Fragen an die Box werden auf jeden Fall auf einem fremden Server ausgewertet, und wir können davon ausgehen, dass sie dort auch gespeichert werden. Selbst daraus kann der Anbieter eine Reihe von Persönlichkeitsprofilen entwickeln, bis hin zu sensiblen Gesundheitsdaten, wenn wir beispielsweise nach bestimmten Medikamenten oder Ärzten in der Gegend fragen.7

Allerdings sind der fast kostenlose Zugang zu fast jedem Titel der Musikgeschichte und die gute Qualität so attraktiv, dass für die meisten Nutzer die Vorteile erheblich größer wiegen als die Datenschutzbedenken. Die Stereoanlage mit CD-Player, lange Zeit der Stolz eines jeden Jugendlichen, wirkt dagegen wie ein Relikt aus der Steinzeit. Das System verbessert sich ständig: Man wird immer seltener missverstanden, wenn man einen bestimmten Musiktitel, Interpreten oder eine Musikrichtung hören will. Mit zwei Boxen erreicht man für einen überschaubaren Preis einen respektablen Stereosound. Die Algorithmen analysieren den Geschmack des Nutzers und bieten ihm immer wieder vergleichbare Titel an, so dass er sich gut bedient fühlt. Alexa kann auch Witze erzählen, die manchmal sogar lustig sind.

Fazit

Chatbots werden immer wichtiger in der Assistenz menschlicher Kommunikation. Solange sie noch als solche zu erkennen sind, können sie zwar nerven, aber nicht sehr viel Schaden anrichten, abgesehen von erheblichen Fragezeichen im Bereich des Datenschutzes. Wenn die synthetischen Stimmen allerdings bald nicht mehr von realen Menschen unterscheidbar sind, wird ein bekanntes Problem noch viel dramatischer: Wie weit sind die Nutzer in der Lage, Richtiges von Falschem, sauber recherchierte Aussagen von Fakes zu unterscheiden? Hier werden neben der Stärkung des kritischen Zweifelns der Nutzer auch die Stärkung von vertrauenswürdigen Medien wichtig sein.

Anmerkungen:

1) Die Studie kann heruntergeladen werden unter: www.freshworks.com.

2) Hierzu vertiefend: detektor.fm.

3) Der Software-Entwickler bietet auf seiner Website einige Anwendungsbeispiele: kaesberg.de.

4) Folgendes Video gibt einen Eindruck davon: www.youtube.com

5) Die Studie kann heruntergeladen werden unter: journals.sagepub.com.

6) Die Studie ist erhältlich unter: www.medienanstalt-nrw.de

7) Ausführlich informiert: Uwe Albrecht:Alexa und Amazon Echo. Smart Home, Steuerung und Datenschutz, Stiftung Warentest, vom 19.11.2019, herunterladbar unter: www.test.de

Quellen:

Braun, A.: Chatbots in der Kundenkommunikation. Wiesbaden 2003

Dvorschak, M.: Künstliche Intelligenz. Der geniale Stimmenklau. In: Der Spiegel, 02.06.2017; abrufbar unter www.spiegel.de

E-Commerce Magazin: Chatbots in der Kundenkommunikation: Warum Kunden sie häufig beschimpfen. In: E-Commerce Magazine, 15.07.2020; abrufbar unter www.e-commerce-magazin.de

epd: Studie sieht Mängel in Nachrichtenangeboten von Sprachassistenten. In: epd medien Nachrichten, 02.12.2021; abrufbar unter w.epd.de

Freshworks: The New Rules of Customer Engagement. Insights from 3000 Global Consumers. 2019 Survey Report. In: United States Survey Report. San Mateo 2019; abrufbar unter: www.freshworks.com

Goppy, G./Dowe, D.: The Turing Test. In: E. Zalta: The Stanford Encyclopedia of Philosophy. Stanford 2003

Hoffmann, A.: Chatbots. Einführung in die Zukunft von Marketing, PR und CRM. München 2018

Huber, F. /Meyer, F./Stickdorn, U.: Online-Avatare zur Steigerung der Markenloyalität. Eine empirische Untersuchung am Beispiel der Marke Ikea. Lohmar 2012

Kaplan, J.: Künstliche Intelligenz. Eine Einführung. Frechen 2017

Lotze, N.: Chatbots. Eine linguistische Analyse. Berlin 2016

Martin, M.: Amazon Alexa: So verhindert ihr, dass eure Gespräche abgehört werden. In: Netzwelt, 07.08.2019; abrufbar unter www.netzwelt.de

Noetzel, S.: Dragon Professional. Die Geschichte der Spracherkennung. Teil 1. In: Nuance, 09.07.2019; abrufbar unter: whatsnext.nuance.com

Roon, A.: Balsam für die Ohren: Was geklonte Stimmen können. In: Breitband, 17.07.2021; abrufbar unter: www.deutschlandfunkkultur.de

Simon, F.: Die Toten übernehmen langsam, aber sicher das Internet. In Neue Zürcher Zeitung, 14.02.2018; abrufbar unter www.nzz.ch

Swiss Moonshot AG: Chatbot-Studie ’21. Dübendorf 2021; abrufbar unter: https://f.hubspotusercontent30.net

Zinner, F.: Digitale Sprachassistenten. Siri, Alexa und Co. hören viel zu oft mit, 07.07.2020. In: MDR Wissen, abrufbar unter www.mdr.de